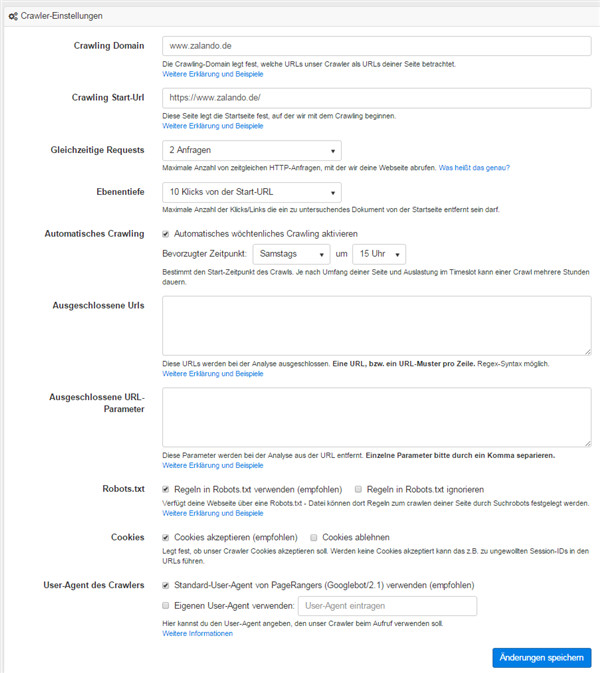

In den Einstellungen legst Du deine Parameter für den PageRangers – Crawler fest. In der Software selbst sind die Erläuterungen dazu hinterlegt. Die Voreinstellungen sind bereits praxistauglich, aber wenn Du ein Feintuning vornehmen möchtest, kannst Du die Einstellungen nach deinem Geschmack verändern und zum Beispiel einige URLs vom Vorgang ausschließen.

Crawling Domain:

Hier legst du die Domain fest, die auf Onpage Faktoren hin untersucht werden soll. Die Crawling-Domain gibt bei der Analyse deiner Webseite vor, welche Webseiten wir als deiner Domain zugehörig betrachten sollen. Wird als Crawling-Domain z.B. die Domain www.example.org angegeben, werden alle Webseiten (URLs) als deinem Webprojekt zugehörig betrachten, welche in ihrer URL mit der Domain www.example.org beginnen. Diese URLs werden auch als “interne” URLs bezeichnet.

Ist die Crawling-Domain mit www.expample.org angegeben, handelt es sich bei folgenden URLs um beispielhafte interne URLs:

- http://www.example.org/Hello/Hello.html

- https://www.example.org/Content/Images/first.jpg

Folgende URLs entsprechen nicht der angegebenen Domain und werden deshalb als “extern” bezeichnet:

- http://www.other-example.org/Hello/Hi.html

- http://example.org/Test/test.html

- http://subdomain.example.org

Findet der Crawler eine externe URLs, analysiert er diese nur auf oberster Ebene, verfolgt jedoch keine weiteren Verweise mehr. Achtung: Sollen im oberen Beispiel auch URLs der Domain example.org analysiert werden, so muss als Crawling-Domain die Domain example.org anstatt www.example.org angegeben werden. Die Domain example.org schließt die Subdomain www.example.org mit ein.

Start-Url:

Ausgehend von dieser URL werden rekursiv alle weiteren verlinkten Seiten, sowie eingebundene und verlinkte Ressourcen (Bilder, Javascript-Dateien, etc.) untersucht. In den meisten Fällen solltest du hier die Start-URL deiner Webseite angeben. Nur in Ausnahmefällen macht es Sinn, hier etwas anderes einzutragen.

Gleichzeitige Requests:

Die Anzahl der gleichzeitigen Requests legt fest, wie viele gleichzeitige Anfragen, wir an deine Webseite senden. Je mehr gleichzeitige Anfragen wir an deine Seite senden, desto schneller wird der Crawlingvorgang abgeschlossen.

Betreibst du eine kleine Webseite, die für eine geringe Last ausgelegt ist, ist es empfehlenswert, diesen Wert relativ niedrig (in den meisten Fällen nur ein gleichzeitiger Request) zu wählen, da unser Crawler sonst deine Seite überlasten könnte. Durch eine Überlastung deiner Seite kommt es zu Fehlinterpretationen der Reaktionszeiten deiner Seite oder PageRangers zeigt dir Seiten als “nicht erreichbar” an, die normalerweise erreichbar sind. Desweiteren werden kleine Seiten von unserem Crawler meistens innerhalb von Minuten komplett untersucht, sodass der Geschwindigkeitsvorteil durch parallele Abfragen nicht zu lasten der Datenqualität gehen sollte.

Für sehr große, auf starke Belastung ausgelegte, Webseiten kannst du einen höheren Wert wählen, falls der Fall auftreten sollte, dass ein Crawling-Vorgang zu lange dauert. Generell empfehlen wir jedoch auch hier erst einmal mit einem gleichzeitigen Request zu starten.

Ebenentiefe:

Hier legst du fest, wie tief der Crawler in die Analyse deiner Seite einsteigt. Empfehlenswert ist eine Seitenstruktur, bei der sämtliche URLs innerhalb von 5 Klicks erreichbar sind. Zur Analyse innerhalb PageRangers kann es dennoch dienlich sein, auch die URLs zu identifizieren, die mehr als 5 Klicks entfernt. Hier lässt sich die Frage stellen, ob ein Umbau der internen Seitenstruktur möglich ist.

Crawling Kontingent:

Mit dem Crawling Kontingent legst du fest, wie viele URLs des Projektes durch den Crawler analysiert werden. Insbesondere bei mehreren Projekten macht eine Verteilung der URLs Sinn.

Automatisches Crawling:

Der Onpage Crawler untersucht deine Webseite einmal wöchentlich zu einem vordefinierten Zeitpunkt. Um das Crawling direkt an deine Workflows anzupassen, empfehlen wir dir, den Crawling Zeitraum selbst zu definieren. Wenn du bspw. immer Dienstags um 8.00 Uhr neueste Ergebnisse benötigst, stell den Crawling Zyklus auf Dienstag 04:00 Uhr. So startet dein Onpage Tag mit frischen Werten.

Ausgeschlossene URLs:

Die Einstellungen zu den “Ausgeschlossenen URLs” geben dir die Möglichkeit einzelne URLs oder URLs die in ein bestimmtes Muster passen, auszuschließen.

Warum sollte ich URLs ausschließen?

Teilweise gibt es URL-Strukturen, mit denen der PageRangers-Crawler nicht umgehen kann, oder welche die Ergebnisse im Optimierungsbereich verfälschen oder “zumüllen”. Meistens handelt es sich hierbei um generierten URLs um Paginations-URLs oder Filternde-URLs abzubilden. Fallen dir solche fast endloses URL-Strukturen in den Ergebnissen auf, kannst du sie durch ein einfaches URL-Muster vom Crawling ausschließen.

Des Weiteren kann es natürlich sein, dass du generell einzelne URLs oder Gruppen von URLs ausschließen möchtest.

Wie lege ich Muster fest?

Die Eingabe für die auszuschließenden URLs, bzw. URL-Muster folgt der Regex-Syntax. Somit kannst du z.B. mit dem eingegebenen Muster

.*?\.jpg

alle URLs ausschließen, die auf “.jpg” enden. Regex-Muster sind ein sehr mächtiges Werkzeug. Im Internet findest du zahlreiche Erklärungen und Beispiele.

Ausgeschlossene URLs:

Die Einstellungen zu den “Ausgeschlossenen URL-Parametern” gibt dir die Möglichkeit einzelne URL-Parameter in den zu analysierenden URLs zu ignorieren. Letzendlich werden diese URL-Parameters aus der URL herausgelöscht, wenn wir eine URL auf deiner Seite finden.

Warum sollte ich URL-Parameter ausschließen?

Teilweise generieren Webseiten dynamische URLs, die quasi endloses URL-Strukturen erzeugen. Sehr oft tauchen diese URL-Strukturen im Zusammenhang mit Paginations oder “filternden URLs” auf. Ein Beispiel wäre z.B. die Ergebnisseite eines Onlineshops, welche 10 Filtermöglichkeiten besitzt und durch Kombination aller Filtermöglichkeiten 10 hoch 10 (= 10000000000) URLs erzeugt.

Es ist selbsterklärend, dass hierbei dein Kontingent an analysierbaren Unterseiten sehr schnell “zugemüllt” wird. Mit dem Ausschluss der entsprechenden Parameter, kannst du dem entgegenwirken.

Wie lege ich die auszuschließenden Parameter fest?

Die auszuschließenden Parameter werden einfach (durch Komma separiert) in das entsprechende Feld eingegeben. Hierbei wird jeweils nur der Parameter, ohne seinen Wert angegeben. Willst du somit bei der URL

http://www.example.org/?category=first

den Parameter “category” ignorieren, fügst du einfach den Parameternamen “category” der Liste hinzu. Die URL wird dann von unserem Crawler auf umgeschrieben.

http://www.example.org/?category=first

Robots.txt

PageRangers kann auf Wunsch alle Seiten erfassen, selbst wenn der Google Crawler durch eine Anweisung in den robots.txt ausgesperrt wurde. Um auf diesen Seiten aber dennoch den Überblick zu behalten, empfehlen wir, die ebenfalls im Crawling zu berücksichtigen. Hier können sich auch Broken Links und übergroße Bilder verbergen, die das Besuchererlebnis schmälern.

Cookies

Legt fest, ob unser Crawler Cookies akzeptieren soll. Werden keine Cookies akzeptiert kann das z.B. zu ungewollten Session-IDs in den URLs führen.

User-Agent des Crawlers

Der User-Agent legt fest, als was sich unser Crawler beim Besuch deiner Webseite ausgibt.Generell hat jeder Browser (bzw. meist sogar jede Browser-Version) eine eigene User-Agent-Kennung.

Die Kennung des Chrome-Browsers in Version 41.0.2228.0 ist z. B.

Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36

Der Crawler von PageRangers gibt sich standardmäßig als Such-Roboter von Google aus. Die Einstellung ist dementsprechend nur zu verändern, wenn z. B. Teilbereiche für den Google Bot gesperrt sind, aber von PageRangers untersucht werden sollen.